Inteligencia Artificial y Análisis inteligente de Datos: ¡¡estadística y matemáticas, no magia!!

Inteligencia Artificial, Machine Learning, Deep Learning, Dispositivos Inteligentes…,- términos con los que constantemente nos bombardean en los medios de comunicación haciéndonos creer que estas tecnologías son capaces de hacer cualquier cosa y resolver cualquier problema al que nos enfrentemos. ¡¡Nada más lejos de la realidad!!

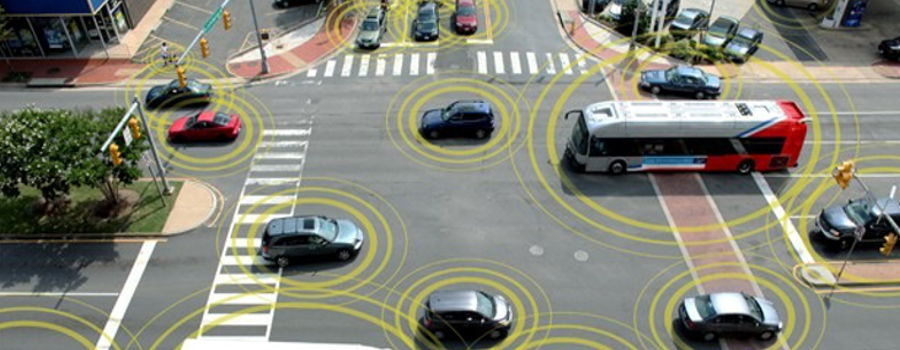

Según la Comisión Europea1, «los sistemas de inteligencia artificial (IA) son sistemas de software (y en algunos casos también de hardware) diseñados por seres humanos que, dado un objetivo complejo, actúan en la dimensión física o digital mediante la percepción de su entorno a través de la obtención de datos, la interpretación de los datos estructurados o no estructurados que recopilan, el razonamiento sobre el conocimiento o el procesamiento de la información derivados de esos datos, y decidiendo la acción o acciones óptimas que deben llevar a cabo para lograr el objetivo establecido»

La IA engloba múltiples enfoques y técnicas entre las que se encuentran el aprendizaje automático, el razonamiento automático y la robótica. Dentro de ellas centraremos nuestra reflexión en el aprendizaje automático a partir de datos, y más concretamente en el Análisis Inteligente de los Datos orientado a extraer información y conocimiento que nos ayude a tomar decisiones. Se trata de esos datos (históricos o en continuo) que son almacenados por las empresas a lo largo del tiempo y que muchas veces no son puestos en valor. Esos datos que reflejan la realidad de una actividad en concreto y que nos van a permitir crear modelos estadísticos y matemáticos (en forma de reglas y/o algoritmos) que contienen información acerca de cómo es la realidad, de cómo son las cosas tal y como ocurren en la actualidad. ¿Cuáles son entonces los actores principales que intervienen en cómo «cocinar» los datos para obtener información relevante? Los datos, que serán nuestros «ingredientes»; los algoritmos, capaces de procesar esos datos, que serán nuestras «recetas»; los informáticos y matemáticos, que serán los «jefes de cocina» capaces de mezclar correctamente los datos y los algoritmos; y los expertos de dominio, que serán nuestros «catadores» particulares y cuyo cometido será validar los resultados obtenidos.

En primer lugar los datos, esos datos a partir de los cuales queremos extraer información con la que generar modelos o hacer predicciones. Mediante un proceso de aprendizaje continuo de prueba y error, basado en analizar cómo fueron las cosas en el pasado, que tendencias había, que patrones se repetían, etc. se pueden generar modelos y realizar predicciones que serán tan «buenas» como lo son los datos. No es cuestión de cantidad de datos, sino de su calidad. ¿Qué significa eso exactamente? Significa que si a un sistema de IA le enseñamos a multiplicar (dándole ejemplos de multiplicaciones correctas) sabrá hacer esa tarea (multiplicar) pero nunca sabrá restar o dividir. Y que si le damos ejemplos ‘incorrectos’ (3*2=9 en lugar de 3*2=6) aprenderá a multiplicar, pero de forma errónea. Necesitamos por tanto que los datos, ingredientes fundamentales de nuestra receta, estén bien organizados, sean de calidad y podamos confiar en ellos (deben ser relevantes).

Por otro lado están los algoritmos de IA, nuestras «recetas» que nos dicen cómo mezclar correctamente los «ingredientes», como utilizar los datos disponibles para intentar resolver nuestro problema. Son algoritmos que nos permiten construir sistemas informáticos que emulan la inteligencia humana a la hora de automatizar tareas. Sin embargo no todos los algoritmos sirven para resolver cualquier tipo de problema. ¿Qué hay entonces en el «interior» de estos algoritmos? Se trata principalmente de fórmulas matemáticas y estadísticas propuestas hace décadas y cuyas bases han avanzado poco en los últimos años, pero que son ahora más efectivos gracias, no solo al aumento en la cantidad de datos que pueden analizar, sino también al aumento en la potencia de cálculo de los ordenadores, que está permitiendo realizar cálculos mucho más complejos, en menos tiempo y a bajo coste. Sin embargo, aptitudes como la intuición, la creatividad o la consciencia son habilidades humanas que (de momento) no hemos conseguido transferir a una máquina de forma efectiva. Serán, por tanto, – nuestros «jefes de cocina» y nuestros «catadores» los encargados de aportar esos factores humanos en nuestra particular «cocina».

Es por ello que no todos los problemas se pueden resolver utilizando IA ¿Por qué? Porque ni los datos son capaces de «hablar» por si solos, ni son «portadores» de la verdad absoluta, ni los algoritmos son «videntes» capaces de adivinar lo impredecible. Lo que realmente saben hacer los datos y los algoritmos es contestar a las preguntas que les planteamos tomando como base el pasado, siempre y cuando las preguntas planteadas sean las adecuadas. Tras el fallo de una máquina, ¿ cómo se relacionan matemáticamente los datos proporcionados por los sensores que monitorizan la máquina con el fallo producido? Cuando se analiza una imagen, ¿ cómo de parecida es a las imágenes que se han analizado previamente? Cuando se le hace una pregunta a un asistente virtual, ¿ qué respuesta se ha dado más habitualmente en el pasado a esa misma pregunta? Se trata, por tanto, de interrogar a los datos de la forma correcta para que nos revelen la información que queremos.

A lo largo del último siglo la IA ha logrado sobrevivir a varios ‘inventos’ tecnológicos con escasez de financiación e investigación, provocados principalmente por el entusiasmo descontrolado que se puso en la tecnología los años previos2. Ha llegado al momento de «aprender» de nuestros datos históricos y no volver a cometer los mismos erros. Reconozcámosle a la IA las capacidades que realmente tiene y dejemos a los magos de su capacidad de hacer realidad lo imposible. Solo de esta forma la IA entrará en una primavera perpetua.

1 https://op.europa.eu/en/publication-detail/-/publication/d3988569-0434-11ea-8c1f-01aa75ed71a1

2 https://link.springer.com/chapter/10.1007/978-3-030-22493-6_2