La consciencia no es computable, es cuántica

Mucho del nuevo bombo alrededor de la Inteligencia Artificial (IA) está directamente relacionada con la potencialidad para imitar o superar las capacidades del cerebro humano (en cuanto a volumen de datos manejados y velocidad de procesamiento) mediante el uso de los ordenadores. El neurocientífico Henry Markram en 2009 anunció un proyecto que pretendía simular el cerebro humano en una super-computadora con diferentes objetivos como «comprender la percepción o la realidad y tal vez incluso comprender también la realidad física».

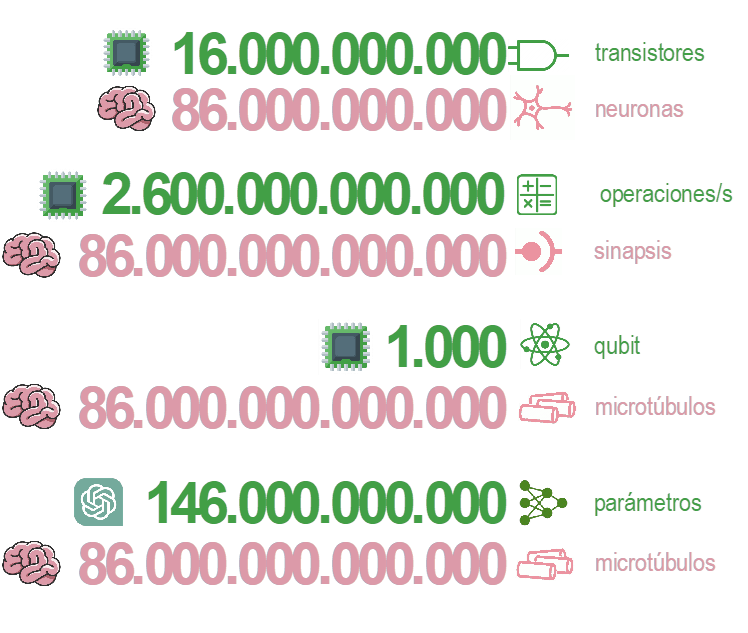

La denominada «singularidad tecnológica» establece como la IA y la robótica nos sobrepasará a los humanos. Hay diferentes predicciones sobre cuándo ocurrirá este apocalipsis. Elon Musk coloca esta singularidad en 2025, el millonario ruso Dmitri Itskov en 2045, por citar varios ejemplos. El continuo avance de las capacidades de los microprocesadores también alimenta, erróneamente, este bombo de la IA. Si uno compara únicamente el número de neuronas (unos 86.000 millones) con el número de transistores del último chip M1 de Apple (16.000 millones) puede estar tentado de asegurar que la «capacidad de computación» del ser humano es fácilmente superable. Lo sé, las comparaciones son odiosas, y en este caso , muy atrevidas.

Hasta hace poco yo también me encontraba entre los expectantes de tales predicciones, pero con un grado de escepticismo razonable. Todo esto cambió para mí en lo más crudo del confinamiento del 2020. Andaba yo deambulando por YouTube en búsqueda de vídeos interesantes relacionados con la IA y llegue a uno muy curiosos y que da título a este post, y que atrajo mi curiosidad: 1la consciencia no es computable. En este vídeo, un más que lúcido Sir Roger Penrose, físico, matemático y filósofo, es entrevistado por el vlogger Lex Fridman, experto en IA y conducción autónoma.

He de decir que, aunque el nivel científico de lo expuesto en el vídeo es muy alto, la lucidez, detalle y afabilidad demostradas por Penrose, me atrapó y logró mantenerme atento durante toda la entrevista. Especialmente, hay una parte que me pega a la silla y me hace rebobinar varias veces para tratar de comprender con el mayor detalle posible. La entrevista empieza directamente con esta tesis demoledora (la mantengo en inglés por ser más fiel): «I´ m trying to say that whatever consciuosness is, it´s not a computation…it´s not a physical process which can be described by computation».

Durante la entrevista, Penrose explicó cómo su curiosidad por la neurofisiología le llevó a explorar los principios básicos de la física, la cosmología, las matemáticas y la filosofía en su libro de 1989 «The Emperor´ s New Mind» para proponer que el pensamiento humano nunca podría ser emulado por una máquina, en contra de las tesis «mainstream» de entonces acerca de cómo las computadoras usando «inteligencia artificial» pronto podrían hacer todo lo que un humano puede hacer.

¿Qué le lleva a asegurar de forma tan tajante la imposibilidad de emular la consciencia humana mediante un ordenador? ¿No se supone que juntando muchos chips de nuestros ordenadores podemos superar el número de neuronas de nuestro cerebro y su capacidad de computación ( si me permitís esa burda comparación)?. Igual que la vida no es un conjunto de células agrupadas en órganos, la «emulación» de las capacidades del cerebro no es una cuestión de agrupar un alto número de transistores y sus impulsos eléctricos. Todos recordamos las explicaciones de cómo las neuronas transportan la información a través de impulsos eléctricos. En su análisis de la fisiología del cerebro, Penrose, ni siquiera al final de su libro pudo llegar a explicar completamente como era posible que las señales nerviosas pudiesen transmitirse mediante impulsos eléctricos de forma coherente por el cerebro. Algo no le cuadraba o le faltaba en su teoría. Pero parece que, a un lector de su libro, el anestesiólogo Stuart Hameroff, fue al único que le cuadró. «Creo que te has olvidado de algo, ¿ no sabes lo que son los microtúbulos?» le dijo a Penrose. «Es lo que te falta para que funcione tu teoría». Los microtúbulos podrían ser la respuesta a la búsqueda de Penrose sobre una fuente no computable en la consciencia humana, desde un punto de vista fisiológico.

¿Pero qué demonios son los microtúbulos? Que me perdonen los biólogos moleculares, pero parece ser que son unas estructuras moleculares de forma tubular que encontramos en las diferentes células de nuestro cuerpo, desde los glóbulos rojos hasta las neuronas. Estas estructuras que «habitan» las interconexiones de nuestras células grises, tienen la propiedad de conservar de una manera muy efectiva su estado (estado de tipo cuántico, pero esto lo dejamos para otro post) y permiten que de alguna forma volvamos a ser los mismos que éramos tras una pérdida de consciencia, por ejemplo, después de una anestesia. Podríamos decir que estos microtúbulos son la unidad almacenamiento (cuántico) básico de nuestro cerebro. Algunos científicos los llaman «el cerebro de la neurona«.

Otra de las razones para poder aspirar a emular el cerebro ha sido poder replicar el número de conexiones que existen entre nuestras neuronas. Es un número bastante grande en realidad. Se estima que cada neurona posee un promedio de 1.000 conexiones. Con 86.000 millones de neuronas esto nos daría unos 86 billones de conexiones. Aunque los números dan vértigo, para algunos expertos parecen conseguibles con la capacidad de cálculo actual en operaciones por segundo (FLOP) de los procesadores. Volviendo al M1 de Apple, este procesador declara ser capaz de efectuar 2.6 TFLOP, 2.6 billones de operaciones por segundo (10 elevado a la 12 ceros). Otra vez, un número aparentemente «cercano» a nuestras conexiones si juntamos un montón de chips trabajando a la vez. Con la aparición fulgurante de chatGPT el debate está más candente que nunca. Sus capacidades ya son casi humanas y sus 175 mil millones de parámetros nos proporcionan una ilusión de comprensión. Pero parece que la consciencia es algo más que conexiones o parámetros de modelo matemático ¿no?

Si nos centramos únicamente en la cuestión cuantitativa y volvemos a los microtúbulos que habitan nuestras neuronas, ¿cuántos de ellos podemos tener? La neurobiología dice que algo más de 1.000 microtúbulos por cada una de nuestras 86 mil millones de neuronas, o sea, 86.000.000.000.0000 microtúbulos (86 billones, similar a las conexiones neuronales) que «almacenan la información cuántica» en la que algunos científicos afirman, reside nuestra consciencia. Podríamos decir en realidad que nuestro cerebro es un ordenador cuántico, ¿no os parece?. Vaya, siento caer de nuevo en una analogía computacional. Volvamos de nuevo a la tecnología para finalizar este post. IBM, promete un ordenador cuántico de 1.000 qubits para 2023. Bastante inferior a los 86 billones de microtúbulos de nuestra cabecita. En mi humilde opinión, y comparando solo aspectos cuantitativos de capacidades de computación actuales y futuras, la denominada singularidad tecnológica informática actual e inteligencia artificial se encuentra aún muy lejos o parece casi inalcanzable. No sé vosotros, pero yo todavía veo un poco lejos la singularidad tecnológica, ¿no os parece?

1 Capacidad del ser humano de reconocer la realidad circundante y de relacionarse con ella