La inteligencia artificial (IA) está contribuyendo a la transformación de un gran número de sectores, desde sugerir una canción de música hasta analizar el estado de nuestra salud con el reloj, pasando por la industria de la fabricación. Un freno a esta transformación es la complejidad de los sistemas de IA usados, lo que a menudo plantea desafíos en términos de transparencia y comprensión de los resultados que ofrecen. En este contexto, se habla de la capacidad de explicación – o “explicabilidad” – de la IA como la capacidad para hacer comprensibles sus decisiones y acciones a los usuarios – es lo que se conoce como IA explicable, o XAI por sus siglas en inglés; algo que es crucial para generar confianza y asegurar una adopción responsable de la tecnología.

Explicabilidad de la IA; capacidad para hacer comprensibles sus decisiones y acciones a los usuarios.

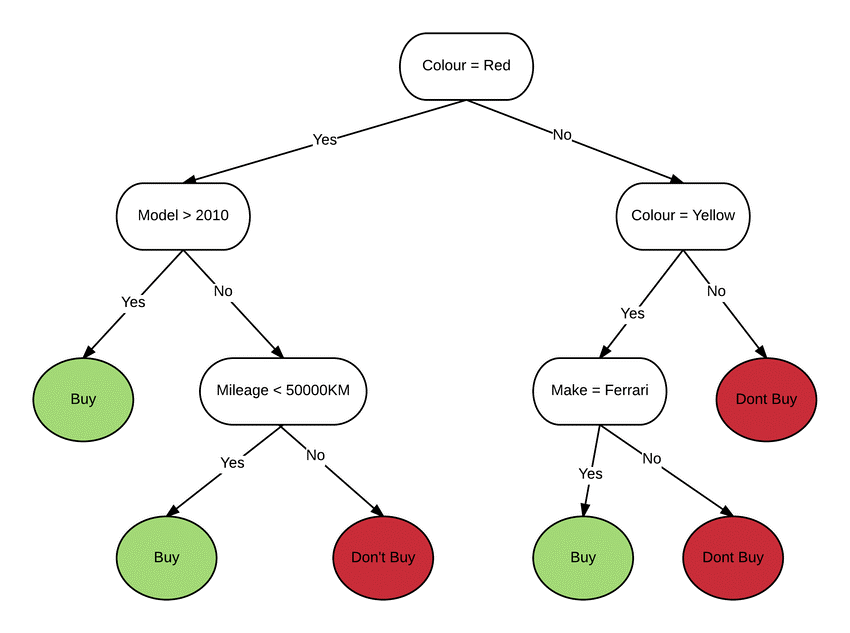

En la actualidad, se trabaja en un amplio abanico de soluciones tecnológicas para mejorar la explicabilidad de los algoritmos de IA. Una de las principales estrategias incluye la creación de modelos intrínsecamente explicables (ante hoc). Estos modelos, como por ejemplo los árboles de decisión y las reglas de asociación, están diseñados para ser transparentes y comprensibles por naturaleza. Su estructura lógica permite a los usuarios seguir fácilmente el razonamiento detrás de las decisiones. Las herramientas de visualización de explicaciones son clave, ya que representan gráficamente el proceso de toma de decisiones del modelo, facilitando su comprensión por parte de los usuarios. Éstas pueden incluir desde cuadros de mando dedicados hasta gafas de realidad aumentada, pasando por explicaciones en lenguaje natural (por voz o texto).

Otra familia de técnicas de explicación comúnmente utilizada es la de los métodos post hoc: éstos consisten en, una vez creado un modelo de IA complejo, procesar y analizar a posteriori el propio modelo resultante para explicar sus resultados. Por ejemplo, algunas de estas técnicas evalúan cuánto contribuye cada variable en la respuesta final del sistema (análisis de sensibilidad). Entre las técnicas de explicabilidad post hoc destaca SHAP (SHapley Additive exPlanations), un método basado en la teoría de juegos cooperativos, que permite extraer coeficientes que determinan la importancia de cada variable de entrada en el resultado final del algoritmo de IA.

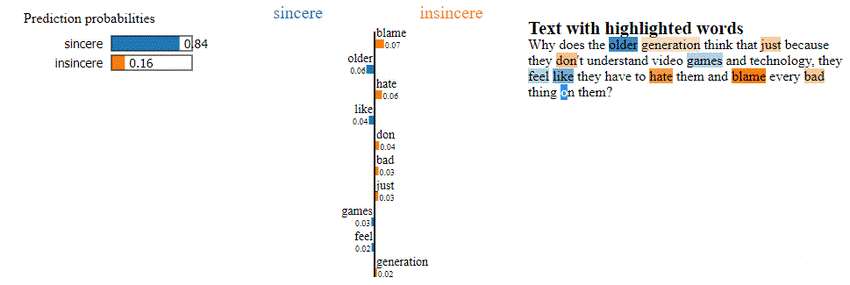

Otras técnicas incluyen la descomposición, que divide el modelo de IA en componentes más simples y más fácilmente explicables, y la destilación en modelos subrogados (knowledge distillation, surrogate models) que aproximan la función del sistema original, pero son más fácilmente comprensibles. Por otro lado, las llamadas “explicaciones locales” consisten en métodos que explican ejemplos individuales (entrada-salida), no el modelo completo. Un ejemplo son las explicaciones proporcionadas por herramientas como LIME (Local Interpretable Model-agnostic Explanations). En el ejemplo de la siguiente figura se explican las palabras más relevantes para determinar por qué el texto se considera ‘sincero’ (con un 84% de fiabilidad) o ‘insincero’ [Linardatos et al. (2020)].

Un enfoque adicional es la integración de entradas de usuarios en el proceso de construcción del modelo, conocido como «Human-in-the-Loop» (HITL). Este enfoque permite a los usuarios interactuar (e.g. etiquetando datos nuevos) y supervisar los algoritmos de IA, ajustando sus decisiones en tiempo real y mejorando así la transparencia del sistema.

En CARTIF, se está trabajando activamente en diferentes proyectos relacionados con IA, como s-X-AIPI para avanzar en la explicabilidad de los sistemas de IA usados para aplicaciones industriales. Un ejemplo significativo de nuestro trabajo son los dashboards (paneles de visualización o cuadros de mando) diseñados para la supervisión y análisis del rendimiento de los procesos de fabricación estudiados en el proyecto. Estos dashboards permiten a los operadores de planta visualizar y entender cómo se está desempeñando el proceso en tiempo real.

Se han creado modelos predictivos y de detección de anomalías para la industria del asfalto que no solo anticipan valores futuros, sino que también detectan situaciones inusuales y explican los factores influyentes en estas predicciones y detecciones. De esta manera, se ayuda a los operarios a tomar decisiones informadas y a entender mejor los resultados generados por los sistemas de IA y como deben actuar.

La explicabilidad en métodos de IA es esencial para su adopción segura y efectiva en todo tipo de sectores: industria, ventas, logística, farmacia, construcción…. En CARTIF, estamos comprometidos con el desarrollo de tecnologías para crear aplicaciones basadas en Inteligencia Artificial que no sólo mejoren los procesos y servicios, sino que también sean transparentes y comprensibles para los usuarios, en definitiva, que sean explicables.

Co-autor

Iñaki Fernández. Doctor en Inteligencia Artificial. Investigador en el área de Salud y Bienestar de CARTIF

- Tras el telón: Inteligencia Artificial Explicable - 12 julio 2024

- Gemelo Digital: la Industria 4.0 en su forma digitalizada - 9 octubre 2023

- Inteligencia Artificial, una inteligencia que necesita datos nada artificiales - 16 diciembre 2022