En la nueva era de la Industria 5.0, los robots dejan de ser simples herramientas de automatización para convertirse en colaboradores activos de las personas. La clave ya no está solo en producir más rápido, sino en lograr entornos productivos flexibles, personalizados y centrados en el ser humano. Y aquí aparece un reto fundamental: ¿cómo conseguimos que los robots entiendan y se comuniquen con nosotros de forma natural?

La respuesta está en la interacción humano-robot (HRI, por sus siglas en inglés). Se busca que las máquinas puedan percibirnos, interpretarnos y responder de manera adecuada. Sin embargo, uno de los grandes obstáculos es la falta de un lenguaje común que permita a distintos sistemas y sensores trabajar juntos de forma armonizada.

En este contexto surge ROS4HRI, un estándar abierto impulsado por nuestro partner en ARISE, PAL Robotics. En este ecosistema, nuestro partner aporta su experiencia en robótica humanoide y social, asegurando que la validación de ROS4HRI se realice en entornos reales, desde laboratorios de pruebas hasta escenarios productivos reales como hospitales y centros de atención sanitaria.

¿Qué es ROS4HRI?

ROS4HRI es una extensión de ROS2 (Robot Operating System) que define un conjunto de interfaces, mensajes y APIs estandarizadas orientadas a la interacción humano-robot.

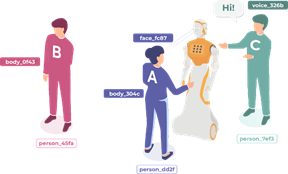

Su propósito es claro: crear un lenguaje común que unifique la forma en la que los robots perciben e interpretan las señales humanas, sin importar qué sensores o algoritmos están detrás. Los robots pueden gestionar información clave como:

- Identidad de la persona: reconocimiento y seguimiento individual.

- Atributos sociales: emociones, expresiones faciales e incluso edad estimada.

- Interacciones no verbales: gestos, mirada, postura corporal.

- Señales multimodales: voz, intenciones y comandos en lenguaje natural.

Arquitectura de ROS4HRI

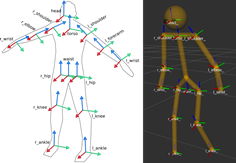

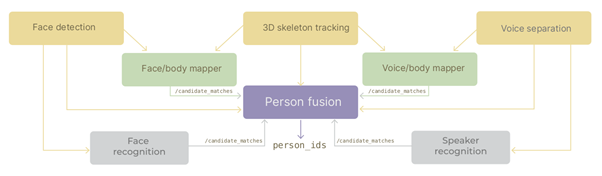

El diseño de ROS4HRI sigue un enfoque modular, derribando las barreras entre distintos sistemas de percepción, asegurando que los robots puedan procesar información humana de manera coherente, independientemente de los sensores o algoritmos que se utilicen, siempre en línea con la filosofía abierta de ROS2. Sus componentes principales son:

- Mensajes estándar: definen cómo representar identidades humanas, caras, esqueletos y expresiones.

- APIs de interacción: facilitan que las aplicaciones accedan a esta información de manera uniforme.

- Integración multimodal: combina datos de voz, visión y gestos para enriquecer la interpretación.

- Compatibilidad con ROS2 y Vulcanexus, que asegura su despliegue en entornos distribuidos.

En la siguiente figura puede verse parte de su núcleo y los distintos módulos que lo conforman. Para quien quiera profundizar, el código y la documentación están disponibles en el repositorio oficial: github.com/ros4hri

ROS4HRI en el ecosistema ARISE

En el proyecto europeo ARISE, ROS4HRI juega un papel clave dentro del ARISE middleware, integrándose con ROS2, Vulcanexus y FIWARE.

Esta combinación permite explorar escenarios de industria 5.0 en los que robots equipados con ROS4HRI pueden:

- Reconocer a un operario y adaptar su comportamiento en función de su rol o gestos.

- Interpretar señales sociales como expresiones de cansancio o estrés para ofrecer un apoyo más humano.

- Compartir información en tiempo real con plataformas de gestión industrial p.e a través de FIWARE, enriqueciendo así la toma de decisiones.

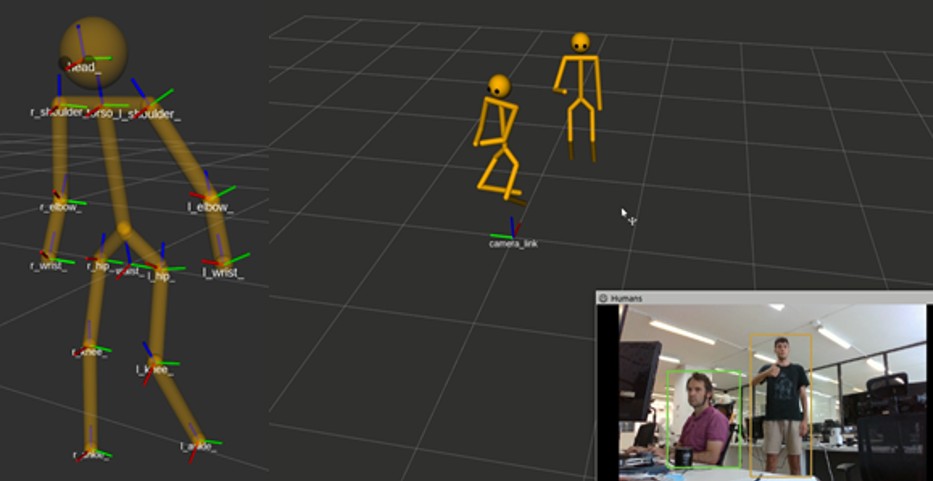

Lo interesante es que ROS4HRI no funciona de manera aislada, sino que se apoya en recursos ya existentes dentro de la comunidad. Un buen ejemplo es MediaPipe, la librería de Google muy utilizada para el reconocimiento de gestos, poses y rasgos faciales. Gracias a ROS4HRI, los resultados obtenidos con MediaPipe (como esqueletos 2D/3D o detección de manos) pueden integrarse de manera estándar dentro de ROS2.

Ejemplo práctico

Un ejemplo práctico en ARISE usando ROS4HRI es la creación de un módulo para detectar los movimientos de los dedos de la mano. Para ello, se desarrolló un paquete en ROS2 que sigue el estándar ROS4HRI y emplea la librería MediaPipe de Google para procesar el vídeo de una cámara.

En este caso el nodo principal extrae las coordenadas 3D de las articulaciones de la mano y las publica en un tópico de ROS siguiendo las convenciones de ROS4HRI, cómo /humans/hands/<id>/joint_states. Gracias a este formato estandarizado, otros componentes del sistema (por ejemplo, un visualizador en RViz o un controlador de robot) pueden usar esos datos de manera interoperable para tareas como control por gestos.

La evolución hacia la Industria 5.0 exige robots capaces de interactuar de forma más humana, confiable y eficiente. En este camino, ROS4HRI se consolida como un estándar clave para habilitar la colaboración humano-robot, garantizando interoperabilidad, escalabilidad y confianza, con aplicaciones que transformarán no sólo la industria, sino también la sanidad, la educación y los servicios.

Referencias

Lemaignan, S.; Ferrini, L.; Gebelli, F.; Ros, R.; Juricic, L.; Cooper, S. Hands-on: From Zero to an Interactive Social Robot using ROS4HRI and LLMs. HRI 2025. https://ieeexplore.ieee.org/document/10974214

Ros, R.; Lemaignan, S.; Ferrini, L.; Andriella, A.; Irisarri, A. ROS4HRI: Standardising an Interface for Human-Robot Interaction.2023 PDF link

Youssef, M.; Lemaignan, S. ROS for Human-Robot Interaction. IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 2021.IEEE link https://ieeexplore.ieee.org/document/9636816

Co-autores

Adrián Lozano. Investigador en la División de Sistemas Industriales y Digitales. CARTIF

Séverin Lemaignan. Investigador Senior responsable de IA Social e Interacciones Humano-Robot en Pal Robotics, socio del proyecto ARISE.